Relic是荒坂一个旗舰级试验项目“守护你的灵魂”的接口和组件。它使用人格转移的概念,将人类神经系统的数据转化为数字印记,然后作为意识体储存在Relic生物芯片上。“守护你的灵魂”的目标就是让你能够与逝去的亲人交流,当然目前只有最富裕的客户才做得到。他们的人格意识体被保存在Relic生物芯片上,也就是说在实际意义上,死亡不再是人类的终极阻碍了。然而,就算是普通人也能明白,Relic技术的潜力远不止如此,目前,荒坂没有透露任何关于该项目未来走向的信息。

——《赛博朋克2077》游戏内数据库

(思路有点散,想到哪儿学到哪儿写到哪儿,时间太零碎了,等全部弄完再整理叭😅)

怎么想的

为了制作父母的虚拟数字人(AI Character)作为原始目标,Gatebox作为成型目标:

1、父母人体&头像3D建模

2、父母的语音库、TTS、Voice assistant

3、人偶开口说话(animation、Lip-sync)

4、3D全息

5、More…(其实前面的东西已经够我喝一壶的了 – -)

除了第一点的头像3D建模在本科毕业阶段研究过,其他都是门外汉,(其实当时也是使用TF-FLAME,基于图片生成的头像3D建模,效果并不精细也不好,答辩的时候院教授问:“为啥建模出来的结果很瘦,和你本人不太像呢?”我只好回答:“因为疫情期间研究这个,吃胖了”。导师们和院教授笑笑也就过去了,挺有趣的一段回忆。

一开始并没有制作父母的AI Character的想法,只是单纯的想用影像记录生活以及一些琐事的回答。在Twitter闲逛看科技新闻的时候,看到日本的Gatebox突然感觉可以朝着这个方向走,一句话介绍Gatebox:是一款专为宅男定制的家用智能化全息机器人。样子就是头图展现的样子。

自己一直是赛博朋克的粉丝,玩了Cyberpunk 2077后,开场的relic芯片的介绍还是很有触动的。relic芯片的介绍像是这个项目的灵魂吧。最近又看到了“赛博母亲”的故事,也是一个很伟大的母亲,她和牛牛一样,是夜之城的大人物。至此,打算把以前的想法再拿出来,看看如何去实现它。

1.人体&头像建模

目标:真人向或二次元卡通向

方案考虑有:

- 3D face reconstruction(效果不好)

- 3D human reconstruction

- 人工建模:Zbrush建模软件等(学习成本很高,但是也会去学习啦)

- Character Creator 4

目前使用的是Character Creator 4 + Headshot插件,这是我力所能及的以图片的形式去快速建模头部,至于身体的方面会有预设的人体,而且还有很详细的部位的调整bar。

2.语音助手(等待更新,使用chatTTS)

updated: 之前使用的是mockingbird AI拟声,现在是用ChatTTS作为替换,原因之一是mockingbird没办法生成和模仿真人的暂停和语气,故使用chatTTS。

原Mockingbird AI拟声流程(被替换)

借此表达一下对稚晖君的赞叹和敬佩,稚晖君太厉害了。得好好看一下稚晖君的语音助手Pico文章。

想要用父母的声音做语音助手,得从头来。(借鉴稚晖君文章里面的思维导图)

- 语音处理:

- 离线唤醒

- ASR

- TTS

- 语音聊天对话

- 智能家居:

- 接入自定义硬件

- 设备消息订阅

- 设备语音控制

- 扩展技能

语音处理

流程:收集父母的音频数据创建数据集;生成模型,调整模型;音频和梅尔频谱图预处理;训练encoder;训练合成器synthesizer;训练声码器。

想要收集音频数据,那一定得有一个麦克风和安静的地方去录音,声音的情绪尽量稳定,不要有‘额’‘嗯’‘啊’‘哈’之类的语气词,电脑端使用adobe audition,audacity等软件或者手机录都行,音频长度最好在2s~10s之间,最后导出为24000采样率的wav格式。录的文本就很随意了,可以是一段电影,一本书,报纸的新闻,手机上的新闻。

数据集整理好后使用:

1、Mockingbird实时语音克隆的开源项目,也可以训练encoder、合成器、声码器。需要先对数据集进行处理,分割音频和字幕(transcript校对文本),为后面进行音频和梅尔频谱图预处理做准备。

2、baidu的Aistudio有个“用你自己的声音做语音合成”,白嫖算力,简化操作。

训练完encoder,合成器,声码器后,使用mockingbird GUI去看看效果如何。

数据集建立步骤(软件篇👨💻)

- Adobe Audition:(八仙过海各显神通哈,有个搜索关键词:Adobe + Genp或者vposy或者CCmaker,都是我大哥🤣)

- RTX Voice:作为一款全新插件,它可以充分利用RTX GPU及其AI功能,在直播、语音聊天、远程视频会议时,帮助消除令人分心的背景噪音。(看到RTX不要怕,现在技术下放了,GTX系列甚至更以前的显卡都可以安装了。

- Whisper-webui:音频出srt字幕的开源程序。有gui其实会简单明了一点,不过这个项目托管在Hugging Face上,注册个账号然后git克隆到本地就好了。源程序在Whisper,如果喜欢命令行式的可以从github克隆。

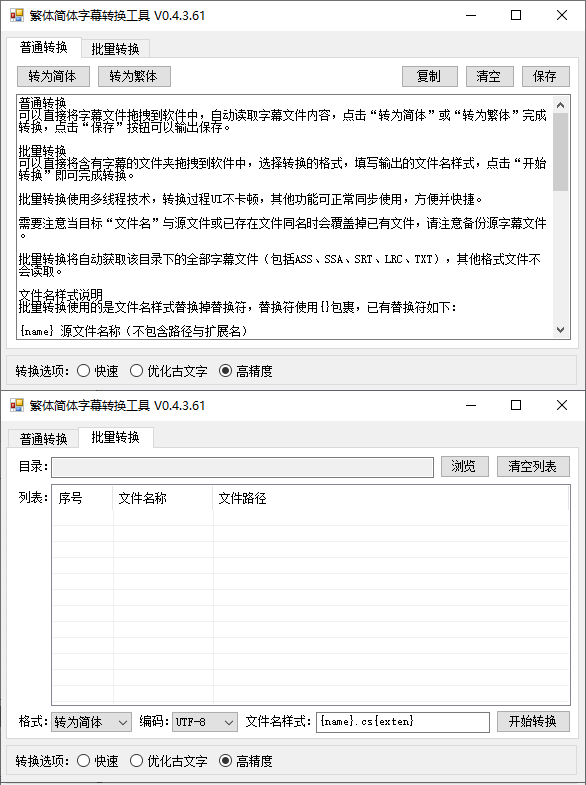

- ChineseSubtitleConversionTool:srt字幕繁简体转换,繁简体字幕转换工具

- SoundLebal:语音数据集制作标注工具,用于从音频文件和srt字幕文件开始制作数据集,用户可以相对方便的在图形界面中编辑数据信息并导出。

- Mockingbird(数据集使用,在这里一起列出来了):AI拟声: 5秒内克隆您的声音并生成任意语音内容,同时训练encoder、合成器、声码器,包括后续测试自己训练出来的声音能不能使用。

数据集建立步骤(开始吧😆)

(因为本人正好单位里有采访的麦克风,所以录音这一步是PC段的步骤,方便性来说用手机录音也可以,但是记得需要一个较为安静的环境,然后后期导出wav,再降噪就好了)

找个麦克风,插上电脑,Audition和RTX Voice配合,给父母录音。Nvidia RTX Voice使用你的麦克风作为输入源,Audition使用RTX Voice作为输入源。(声音从RTX Voice输入并且降噪,然后被Audition录制下来,效果非常好,就算周围环境有点点嘈杂,背景音也会被降噪的很好)

录音的文本的话,我找了《汉语日常对话》和《现代汉语语料库》,后者直接搜关键词,可以直接网页使用(下载语料是xls格式,用Excel打开格式有点奇怪,推荐直接网页使用吧,拿个平板让父母读就好了)

Audition新建一个音频文件,采样率48000Hz(2w4*2),声道就选择单声道就好了,最后录制完成最后保存成wav文件就完事儿了。

有了录音文件,那还需要声音的transcripts(声音的文本?😅)还得处理一下,Whisper-webui就闪亮登场了。Whisper把读的那些话识别成Srt字幕文件,有时间戳后面方便点。

Srt下载好是繁体字,使用繁简体字幕转换工具,把字幕拖进软件=>转为简体=>保存

好了,我们手上有了Wav和对应的Srt,但是很长咋办0 0。尊敬的SoundLebal登场。把wav和srt都放进filepath文件夹

SoundLebal导出数据集后,在filepath中会生成一个output文件夹,存放分段好的wav音频和transcript文本。Mockingbird的作者在炼丹文中和github issue中说,训练集长度最好是小时级的,聚沙成塔吧少年,慢慢来 不着急。训练集时长越长,后续训练应该越准确😇(数据多嘛,能更好的学习呗)

吼了,到此数据集算是搞出来了,这一部分还挺花时间的,我是没本事把所有的软件整合成一个软件啦,(写不了!没这个能力知道伐?范志毅.gif😂),顶多写个windows forms app 把上述用到的软件做个缝合怪🙄

2.1 ChatTTS

(未完待续….)

3.Lip-sync

《人体&头像建模》中如果选择真人向,考虑使用类似于wav2lip的开源项目,二次元向往MMD制作方向靠近吧。